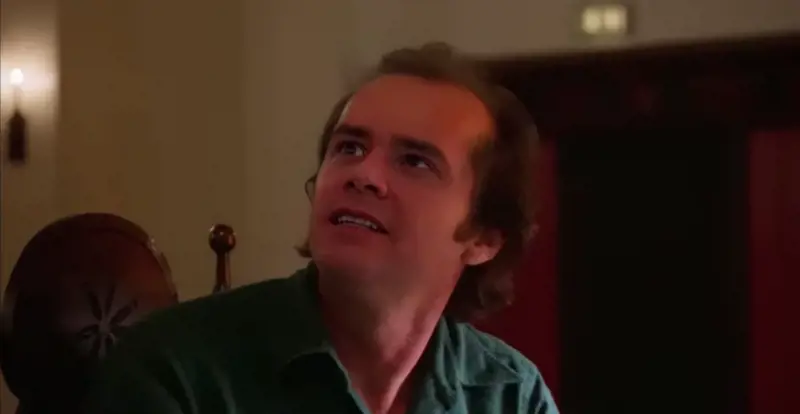

Il video è stato pubblicato ieri ed è stato visto già da - quasi - un milione di persone. Nel filmato, realizzato dallo youtuber Ctrl Shift Face si vede una scena estratta dal celebre capolavoro di Stanley Kubrick, Shining. Nella pellicola Wendy Torrance si avvicina alla scrivania dove lavora il marito scrittore Jack Torrance, che nel lungometraggio di Kubrick è impersonato da Jack Nicholson: nel filmato diffuso sul web, tuttavia, il suo volto è stato sostituito da quello di Jim Carrey, pettinato e vestito come il protagonista del film. Lo youtuber è noto e abile nel creare video manipolati di questo genere che, come spiega il Corriere della Sera, hanno un nome ben preciso: "deepfake". La parola unisce "fake" (falso) a "deep", che significa "profondo" e allude al deep learning, l’apprendimento profondo di cui sono capaci alcuni sofisticati algoritmi di intelligenza artificiale.

Sul web - in particolare su Youtube - di esempi di questo genere ce ne sono a bizzeffe. Lo stesso Ctrl Shift Face ha realizzato un video di Terminator 2 sostituendo l'attore originale del film - Arnold Schwarzenegger - con Sylvester Stallone. "I video e gli audio falsi continuano a migliorare, a essere più veloci e facili da realizzare, aumentando il potenziale di danno di una tecnologia strabiliante se messi nelle mani sbagliate" spiega Bloomberg, che in un video mostra alcuni esempi di "deepfake". Insomma, finché programmi come DeepFaceLab vengono usati per realizzare filmati divertenti e per intrattenimento va bene: ma se si impiega questa tecnologia per altri scopi - politici, militari - allora i rischi diventato seri.

Come riporta IlSole24Ore, CBInsights, in un report, riporta una ricerca effettuata da alcuni scienziati dell’Università di Washington. Gli esperti hanno dapprima preso un file audio di Barack Obama. Successivamente, utilizzando un sistema neurale, hanno individuato, attraverso l’analisi di milioni di immagini dell’ex presidente degli Stati Uniti, diverse forme e posizioni casuali della sua bocca e dei suoi movimenti. Poi l’artificial intelligence (Ai) ha definito la corretta sequenza delle posizioni che si adattava al file audio. Successivamente il filmato "costruito" della parte inferiore della faccia di Obama è stato sintetizzato all’interno di un video in cui l’ex inquilino della Casa Bianca diceva tutt’altro. L’Ai è stata in grado non solo di ricomporre i movimenti della bocca ma anche particolari quali, ad esempio, il movimento delle rughe attorno alle labbra oppure al mento. Nel risultato finale Obama pronuncia una frase detta in tutt'altra occasione.

Per mezzo di questa tecnologia, sul web sono stati diffusi dei filmati pornografici con attrici famose: nel mirino dei video manipolati sono finite Katy Perry, Scarlett Johansson, Daisy Ridley e Jennifer Lawrence. Ma la diffusione di filmati manipolati preoccupa anche gli esperti di sicurezza. Come sottolinea Foreign Affairs, i "deepfakes" hanno il potenziale per essere particolarmente distruttivi perché stanno proliferando in un momento in cui sta diventando sempre più difficile separare i fatti dalla finzione. L'uso di frodi, falsificazioni e altre forme di inganno per influenzare la politica non è una novità, ovviamente. Quando la Uss Maine esplose nel porto dell'Avana nel 1898, i tabloid americani usarono resoconti fuorvianti dell'incidente per istigare il pubblico alla guerra con la Spagna.

Tuttavia, questi video manipolati, sottolinea la prestigiosa rivista americana, potrebbero essere impiegati dagli attori non statali, come i gruppi di insorti o le organizzazioni terroristiche, che possono creare e diffondere contenuti audio o video falsi ma credibili.

"Un affiliato dello Stato Islamico (o ISIS) - scrive Foreign Affairs - per esempio, potrebbe creare un video che raffigura un soldato americano che spara civili o discute un piano per bombardare una moschea, aiutando la formazione terroristica a reclutare nuovi miliziani. Questi video sarebbero particolarmente difficili da ridimensionare".