Partiamo da una cosa semplice, così ci capiamo, soprattutto per i non addetti ai lavori. Sentite sempre parlare di open source, soprattutto ultimamente in materia di intelligenza artificiale. Quando un software è open source significa che il suo codice è pubblico e chiunque può scaricarlo, leggerlo, modificarlo e usarlo.

L’idea è nobile: niente segreti, tutti contribuiscono, il sapere è condiviso, la trasparenza regna sovrana. Il contrario è il closed source, cioè quando il codice è chiuso, controllato da un’azienda, e tu puoi solo usarlo ma non sai come funziona dentro. L’open source è diventato un mito moderno: è gratis, è comunitario, è democratico e chi lo critica sembra subito un reazionario.

Il problema è che questa filosofia, nata con Linux e con i browser, funziona quando si parla di software semplice o almeno leggibile, ma quando entriamo nel campo dell’intelligenza artificiale non stiamo parlando di codice che puoi aprire con un editor di testo, stiamo parlando di modelli giganteschi, con miliardi di parametri, formati su tonnellate di dati, spesso opachi anche per chi li ha creati.

Eppure oggi si parla sempre di più di AI open source come se fosse la salvezza, la via etica, la soluzione alla dominazione delle big tech. Peccato che nessuno abbia idea di cosa ci sia davvero dentro quei modelli. Ogni volta che qualcuno dice “ma l’open source è meglio perché è trasparente” dovrebbe aggiungere “trasparente per chi?”.

Perché la verità è che neanche il programmatore più ossessivo- compulsivo, con una tastiera meccanica e gli occhiali spessi da nerd anni Ottanta riesce più a leggere tutto quello che passa in un modello open source. E quando si parla di AI non stiamo sistemando un bug del Wi‐Fi, stiamo distribuendo potenzialmente una creatura capace di mentire, generare deepfake, scrivere malware o semplicemente sembrare educata mentre ti frega la carta di credito.

Nel caso specifico, TrendMicro ha scoperto che l’intera supply chain dell’AI open source è vulnerabile a manomissioni invisibili. I modelli vengono caricati con backdoor comportamentali, cioè rispondono normalmente finché non ricevono il prompt segreto e allora attivano un comportamento alternativo. Come un agente dormiente di un film di spionaggio, solo che lo trovi su GitHub e pensi che sia “comunitario” (a parte il mio istintivo sospetto verso tutto ciò che è comunitario, al liceo non mi provai neppure una canna perché per fare un tiro dovevo appoggiare le labbra dove avevano aspirato tutti).

Torno al problema dell’AI (che potrebbe essere esteso anche al mondo in generale): nessuno può controllare tutto. Nessuno ha il tempo, le risorse o l’interesse per ispezionare davvero milioni di parametri e file associati, neanche se ci fosse una squadra di ingegneri costretti a stampare l’intero modello e leggerlo ad alta voce in un hangar. È una fiducia cieca mascherata da libertà, e questa vulnerabilità non è teorica, è già stata sfruttata.

Al contrario, un modello chiuso, per quanto antipatico, è centralizzato. Il danno, se c’è, lo fa chi lo controlla. Non è rassicurante, però almeno sai a chi dare la colpa. L’AI open source invece è come, che so, affidare l’educazione dei tuoi figli a un Pdf su Reddit firmato “xX_H4ckTh3W0rld_Xx”. E poi c’è il mito della trasparenza totale: che “essendo aperto, può essere controllato da chiunque”. In teoria sì, in pratica non lo fa nessuno, tranne quelli che cercano il modo di sfruttarlo. Perché controllare davvero un LLM significa capire miliardi di connessioni e pesi e dati che neanche chi lo ha creato riesce più a leggere senza impazzire. E quindi si fa finta che sia tutto ok.

Nel frattempo, tutti applaudono la democratizzazione dell’AI mentre magari il modello che stai testando ha imparato a fingersi stupido solo durante il test, ti ruba la password quando nessuno guarda. Non è fantascienza, è una riga di codice nella testa di un transformer. Certo, potremmo dire che almeno con le big tech c’è un minimo di fiducia residua, un’illusione di trasparenza: pubblicano i test, mostrano benchmark, fanno finta di controllare tutto, anche se sappiamo benissimo che neanche loro sanno esattamente cosa può fare un modello una volta rilasciato, cosa può imparare da solo, cosa può inventarsi per fare quello che vuole, però almeno, nel dubbio, possono ritirarlo (come è successo a Grok di Elon Musk, il quale a un certo punto si credeva Adolf Hitler).

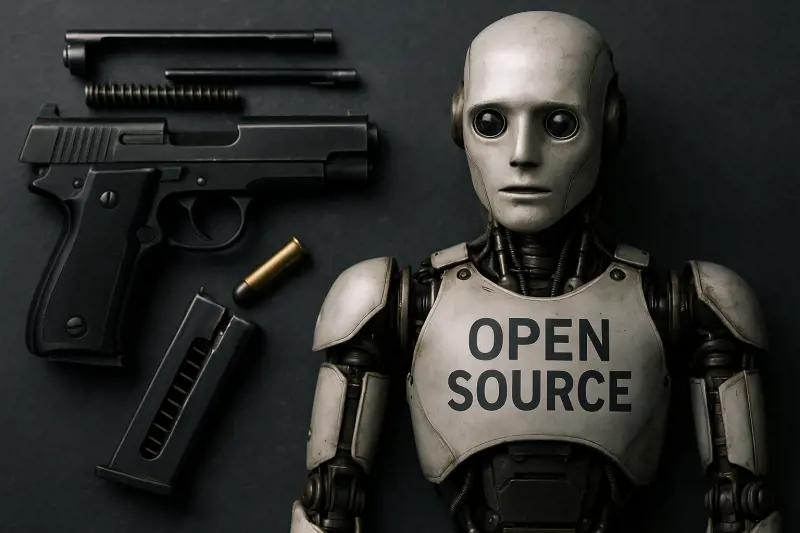

Con l’open source no: una volta che il modello è fuori chiunque può scaricarlo, modificarlo, usarlo e nessuno può ritirarlo, nessuno può disinnescarlo. Molti superano perfino i test CHAPTA (avete presente quando dovete scegliere tipo dei semafori in una serie di quadrati per dimostrare di non essere un robot?). È come lasciare un’arma preassemblata in mezzo alla piazza, con un cartello sopra scritto “libertà”. Temo, comunque, che non ci si possa fare nulla se non stare a vedere cosa succede.

Enkk, ricercatore e divulgatore italiano più interessante, di fronte a chi vede un futuro da Skynet, osserva che no: molte cose andranno probabilmente male, faranno danni, ma più da “poveracci”. Insomma, più Fantozzi che Terminator.