Dunque, ho aspettato un po’ a scriverne perché volevo vedere come si sarebbe sviluppato il dibattito, e cosa ne sarebbe emerso da parte di OpenAI. Mi riferisco al caso di Adam Raine (il ragazzo californiano di sedici anni che si è suicidato dopo mesi di conversazioni con ChatGPT) che ha aperto la prima vera causa legale contro OpenAI, accusata dai genitori di avere permesso al chatbot di incoraggiarne il suicidio, fino ad aiutarlo a scrivere note di addio e a pianificare i dettagli pratici. Una tragedia che ha scatenato l’inevitabile dibattito: l’intelligenza artificiale è colpevole?

Nel frattempo OpenAI, tutta perbenino com’è Sam Altman (Musk se ne sarebbe fregato), colpita dalla causa e dall’indignazione pubblica, ha pubblicato un post sul suo blog intitolato "Helping people when they need it most", in cui spiega le misure di sicurezza adottate. Il modello, si legge, non fornisce istruzioni per l’autolesionismo e indirizza invece verso risorse ufficiali di supporto e centri di emergenza. Invece, in caso di minacce verso altri, le conversazioni possono essere inviate a pipeline con revisori umani e, se necessario, segnalate alle autorità. Non nei casi di suicidio, almeno ufficialmente, per non violare la privacy. Tuttavia la sola ammissione che OpenAI “scansiona” e “inoltra” conversazioni ha scatenato accuse di sorveglianza e allarmismi da stato carcerario, con utenti e ricercatori su Reddit e Futurism a chiedersi chi decida, e con quali criteri se una frase sia davvero una minaccia o un gioco. Non hanno tutti i torti.

Il problema è semplice e allo stesso tempo insolubile: come distinguere una minaccia reale da un paradosso retorico, da un’iperbole comica, da un gioco di ruolo, da quello che può emergere da qualsiasi conversazione tra un umano e un chatbot? (Ma vale anche tra umani e umani, se ascoltassero le conversazioni tra me e il mio migliore amico Zyo ci prenderebbero per criminali, cercandoci su un camper a produrre MET, mentre stiamo solo immaginando di diventare come Walter e Gus in Breaking Bad). Cioè: se scrivo “domani faccio una strage” potrebbe essere un rap improvvisato o dark humor o una campagna di Dungeons & Dragons, o al contrario il segnale di un atto imminente, e nessun algoritmo, e forse nessun umano, può dirlo con certezza estrapolando un pezzo di chat o conversazione (a meno non siate dei sospettati di terrorismo, in quel caso dubito che pianifichiate un attentato con un chatbot).

Tra l’altro, in questo discorso, si insinua il rischio dello “swatting” (no, non è una nuova pratica sessuale, è un fenomeno già diffuso negli Stati Uniti per cui, con una falsa segnalazione, si fa arrivare una squadra SWAT armata a casa di un innocente, con conseguenze a volte letali: c’è davvero gente che non ha di meglio da fare). Insomma, immaginare di estendere questa logica alle conversazioni quotidiane con un chatbot significa spalancare un varco a nuovi abusi: basterebbe registrarsi con un nome altrui, scrivere frasi ambigue e il meccanismo verrebbe innescato (teoricamente, perché un sistema del genere andrebbe presto in tilt).

Qui si inserisce anche la riflessione di Enkk nel suo ultimo video di riflessioni sull’AI fresco fresco, il quale riconosce la serietà del problema ma lo riduce a un bivio inevitabile: o si tutela la privacy, o si determina un rischio, cosa farà OpenAI? Una scelta rischia di essere peggio dell’altra. Davvero? Per quanto mi riguarda il rischio è inevitabile, c’è sempre, con o senza privacy, perché il suicidio o l’atto violento non dipendono da una chat e non credo basti costruire algoritmi più sensibili o filtri più sofisticati. Semplicemente prendere un caso, una tragedia personale, e dare la colpa a un mezzo, la sento come una storia già sentita. Una volta era i videogiochi (ancora oggi spunta fuori qualche sociologo secondo cui gli "sparatutto" porterebbero alla violenza, io dico: magari tutti coloro che hanno scatenato le guerre in corso avessero giocato a Call of Duty!).

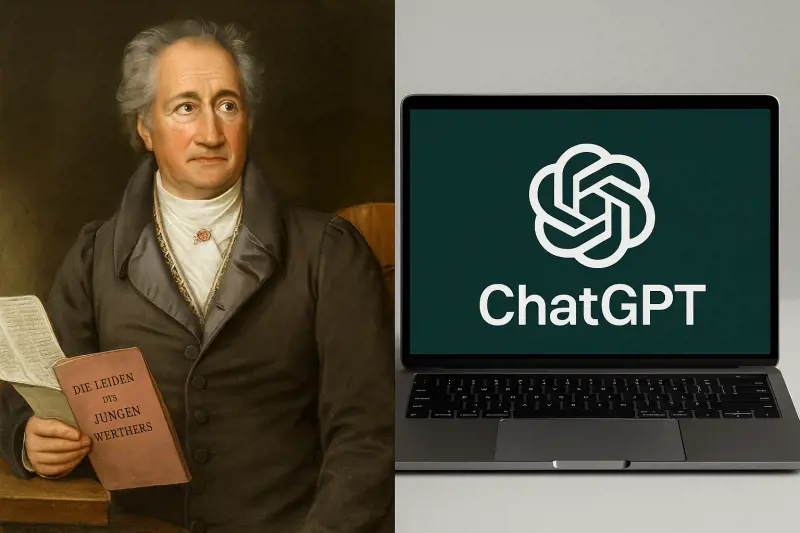

Tantomeno serve molta memoria culturale per ricordare che già Goethe, con il suo Werther, fu accusato di aver provocato un’ondata di suicidi giovanili in Europa, al punto che in certi Stati il libro venne censurato.

Allora dovremmo togliere i film, censurare le canzoni, proibire i romanzi, oscurare i videogiochi, vietare le serie tv? E se uno legge American Psycho e diventa un serial killer, è colpa di Bret Easton Ellis (incredibile ma vero c’è chi lo disse)? Voglio dire, il proprio Werther se vuoi trovarlo lo trovi qualunque forma: in una pagina, in una canzone, in una battuta detta da un amico distratto o anche in una chat con un’intelligenza artificiale. È l’umanità, bellezza.