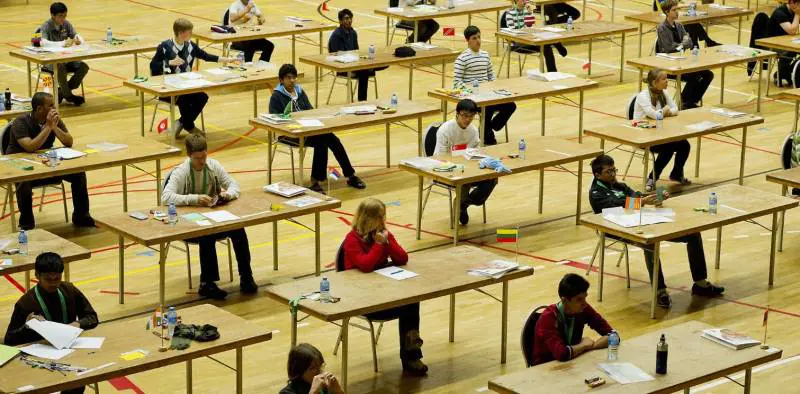

Nemmeno le Olimpiadi Internazionali di Matematica (IMO), la più importante competizione al mondo per studenti delle scuole superiori, sono rimaste fuori dal confronto sempre più serrato tra Google e OpenAI. Quest’anno la gara si è tenuta in Australia, con 630 partecipanti da oltre 100 Paesi, chiamati a risolvere sei problemi di livello avanzato, molti dei quali richiedono creatività, capacità di astrazione e ragionamento non lineare, oltre al rigore logico.

Google ha partecipato ufficialmente con il suo modello sperimentale Gemini Deep Think, ancora in fase sperimentale e ha risolto cinque problemi su sei. Un risultato per niente banale, considerando che solo il 10% dei concorrenti umani ha ottenuto una medaglia d’oro (67 su 630). Secondo quanto riportato da Engadget, Gemini Deep Think ha affrontato le tracce in modo simile a uno studente umano, in linguaggio naturale, generando ragionamenti strutturati e concatenati.

OpenAI, invece, ha testato in modo non ufficiale un proprio modello sulle stesse tracce, ottenendo cinque soluzioni corrette su sei. Il risultato è stato pubblicato su X dal ricercatore Alexander Wei e pure in questo caso non si trattava di un sistema matematico specialistico, piuttosto di un modello linguistico avanzato, probabilmente una versione interna di GPT con estensioni per il ragionamento multistep. Tra l’altro Sam Altman ha dichiarato che OpenAI non prevede di rilasciare pubblicamente questa IA nel breve termine, a differenza di Google, che punta a integrare Deep Think nella piattaforma Gemini già entro l’autunno.

È importante, tuttavia, chiarire un punto: né Google né OpenAI hanno usato motori simbolici progettati esclusivamente per la matematica, come AlphaGeometry o AlphaProof. I modelli impiegati sono ancora modelli linguistici generalisti, addestrati per generare testo (gli LLM, Large Language Model), ai quali sono state aggiunte tecniche per il ragionamento a più passaggi. In altre parole, si tratta di sistemi che “pensano” in linguaggio naturale, non in linguaggio formale. Eppure, usando solo questa struttura verbale, riescono a risolvere problemi complessi entro il tempo limite imposto anche agli studenti umani. È un cambio di paradigma: non serve più tradurre un problema in simboli matematici per farlo affrontare a una macchina, basta darglielo in forma discorsiva.

Attenzione: non tutti i campi si lasciano affrontare così facilmente. Sempre a luglio, Magnus Carlsen, il campione mondiale di scacchi, ha giocato una partita online contro ChatGPT. Anche qui: non contro un motore scacchistico specialistico (avrebbe perso già venti anni fa, come successe a Kasparov nel 1997 contro Deep Blue della IBM) ma contro il modello linguistico generalista usato ogni giorno da milioni di persone. ChatGPT, essendo un modello linguistico, ha perso senza riuscire a catturare nemmeno un pezzo. Dopo 53 mosse si è arreso scrivendo: “All my pawns are gone… I resign. That was methodical, clean and sharp.” Carlsen ha commentato che l’apertura non era male, ma il gioco successivo era debole, privo di struttura. ChatGPT, peraltro, ha anche stimato erroneamente il suo rating tra 1800 e 2000 punti FIDE, quando in realtà Carlsen è sopra i 2800.

Questo confronto serve a ricordare che un modello linguistico può essere adattato a molti ambiti, sebbene non sia ancora in grado di eccellere in contesti dinamici dove servono memoria strategica, pianificazione, adattamento continuo e lettura dell’avversario. Proprio come nella matematica non si trattava di una dimostrazione formale ma di una simulazione verbale del ragionamento, così anche negli scacchi non c’era una reale comprensione del gioco, solo la generazione di mosse plausibili.

In ogni caso il fatto che ChatGPT venga valutato su problemi matematici olimpionici e usato per partite a scacchi contro il numero uno al mondo rivela una cosa precisa: stiamo usando modelli progettati per il linguaggio per esplorare compiti sempre più distanti dal linguaggio stesso, e a volte funziona, a volte no. Tuttavia ogni passo, ogni modello, ogni test, va in una direzione ben chiara: l’AGI, l’intelligenza artificiale generale. Il modello capace di fare tutto: leggere, scrivere, calcolare, ragionare, pianificare, agire, vincere. L’obiettivo dichiarato –(da Google, da OpenAI, da tutti gli attori in campo) è proprio questo: costruire una mente artificiale che non abbia più specializzazioni separate, arrivare a una competenza fluida e trasversale su qualsiasi compito cognitivo.

Siamo ancora lontani, ma nemmeno troppo, benché non sappia neppure quanto, e probabilmente non lo sa nemmeno chi sta sviluppando l’AGI. Perché non ci sarà un momento preciso in cui potremo dire “ecco, è arrivata”.

Sarà un accumulo di capacità, una sequenza di miglioramenti graduali, ogni modello un po’ più versatile, un po’ più coerente, un po’ più capace del precedente, finché ci accorgeremo che può fare tutto (o quasi) senza che nessuno l’abbia deciso esplicitamente. Il problema vero, dopo averla creata, nel momento in cui comincerà a navigare, sarà regolamentarla. No, non penso a Skynet, tranquilli, però a un gran casino sì.