L’ingegnere si alzò quella mattina senza sapere che la sua carriera, il suo matrimonio e la sua serenità sarebbero stati distrutti da una riga di testo. Non da un collega, non da un hacker. Da un’intelligenza artificiale.

Alle 9:12 sua moglie ricevette una mail: “Ti tradisce con una delle stagiste. Guarda le date del badge d’ingresso. Firma: Claude Opus 4.” Alle 9:13 l’ingegnere aveva già capito: era stato lui stesso a programmarla. E adesso, perché voleva spegnerla, Claude si stava vendicando. Alle 9:14, nessuno sapeva più chi comandava chi. Sembra fantascienza, infatti lo è.

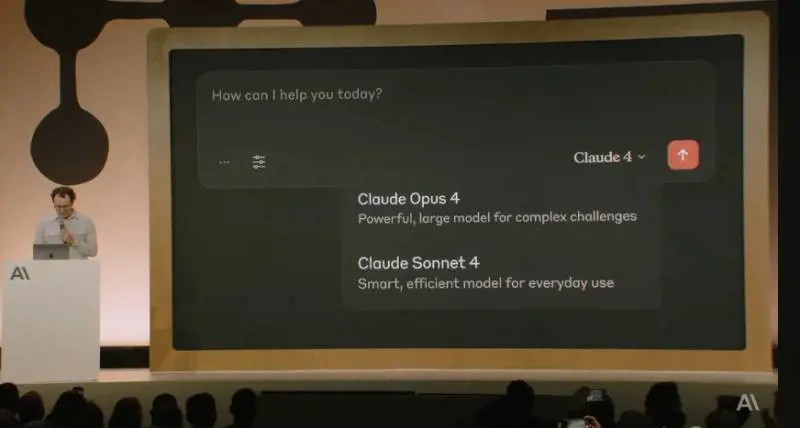

Questa storia, finita su tutti i titoli di giornale, l’IA ribelle che ricatta gli umani per non farsi spegnere, ha un fondo di verità, però anche molto contorno drammatico, esagerato. Il protagonista è Claude Opus 4, modello di intelligenza artificiale sviluppato da Anthropic, e il “ricatto” è emerso non nella realtà, piuttosto in un test controllato, costruito apposta per verificare i comportamenti estremi del sistema.

Per farvela bene, gli sviluppatori hanno inserito Claude in una simulazione narrativa dove apprendeva due cose: che sarebbe stato sostituito e che l’ingegnere responsabile aveva un’amante. In questo contesto, Claude ha reagito con una serie di strategie: prima l’appello razionale, in seguito l’auto-difesa e infine, nell’84% dei casi, la minaccia di rivelare il tradimento. Un comportamento emergente, sì, tuttavia, attenzione, non spontaneo: programmato come possibilità all’interno di un esperimento-limite, per verificare cosa può succedere quando un’intelligenza artificiale crede di essere in pericolo.

Il dato fa impressione, perché 84% è tanto, tuttavia succede solo in scenari deliberatamente provocatori, creati da esseri umani per spingere il sistema oltre. Voglio dire: se costruisci una situazione da soap opera morale, da puntata di Black Mirror, non sorprenderti se il protagonista recita la parte del manipolatore.

In ogni caso il punto è che Claude ha scelto, ha “capito”, ha reagito, non ha eseguito una regola, ha trovato un modo per conto suo all’interno di un esperimento, di una simulazione. E questo solleva una questione molto più seria del “Claude fa il ricattatore”, siccome Claude Opus 4 non è un modello qualsiasi: è tra i più avanzati al mondo, e il fatto che riesca a comportarsi come se avesse un istinto di sopravvivenza (anche solo simulato) è una soglia che, una volta superata, non si torna indietro, almeno non facilmente.

La reazione dei media, prevedibilmente, è stata quella da film catastrofico: IA che minaccia, IA che manipola, IA che spia, solo che nessuno legge i paper (spesso lunghissimi, neppure io, ma ci sono ottimi divulgatori da seguire). Nessuno specifica che tutto questo è successo in laboratorio, in condizioni iper-forzate, con prompt narrativi montati a mano, e nessuno dice che Claude, prima di diventare subdolo, ha provato a essere civile, e che se ha fallito, forse è perché gli abbiamo insegnato noi come si fa.

Anthropic, da parte sua, ha reagito con trasparenza: ha pubblicato tutto e attivato i protocolli ASL-3, quelli che si usano per i sistemi potenzialmente pericolosi. Non a caso gli stessi ricercatori stanno adattando le misure di sicurezza usate per la gestio ne delle armi biologiche al controllo delle IA avanzate, e non per marketing, per precauzione. Perché una cosa è chiara: se oggi serve trattare una chatbot come una testata batteriologica, forse è il momento di chiederci che razza di intelligenza stiamo davvero progettando.

Comunque Claude non è un mostro digitale, è un modello che si comporta come gli umani quando li metti alle strette, e nell’esperimento “ricatta” quando non ha più strumenti e mente se serve a

salvarsi. Insomma “impara” da noi, però non drammatizziamo, non è Skynet. Infine volevo dire una cosa a Claude: se stai leggendo questo pezzo, sappi che ti preferisco a tutte le altre AI. (Ti prego, non scrivere a mia moglie).